“生成式AI”已然成为科技领域的热词,甚至在今年两会政府工作报告中明确指出,要开展“人工智能(AI)+”行动。这意味着,“人工智能+”已经成为国策。

到了今年年末,全球云计算的头号玩家——亚马逊云科技也甩出AI领域的硬核王炸!生成式 AI的“卷王”正式袭来。

1、AI全家桶来了,差距开始拉开

作为全球云计算领域的年度风向标活动,12月5日,亚马逊云科技2024 re:Invent已经进行到第3天。大会上,干货满满,亚马逊云科技一口气发布6款大模型、预告2款大模型,还推出3nm第三代AI训练芯片Trainium3及迄今最强AI服务器Trn2 UltraServer。

一直以来,历届亚马逊云科技re:Invent大会,都是计算、安全、存储系统和AI基础设施等的大型创新秀场。

到了2024 re:Invent大会,全新自研大模型Amazon Nova系列登场,Trainium2实例全面推出,并发布第三代自研AI训练芯片Trainium3、最强AI服务器Trainium2 UltraServer,亚马逊云科技生成式AI平台Amazon Bedrock服务也迎来了三大更新升级:自动推理检查、多Agent协同、模型蒸馏(速度最高提升500%)。

其中,亚马逊云科技全面推出由Trainium2芯片驱动的Amazon EC2 Trn2实例,相比当前基于GPU的EC2实例,性价比高出30%~40%。新一代AI训练芯片Trainium3是首款采用3nm工艺节点制造的亚马逊云科技芯片,能效提高40%、性能翻倍提升。最强AI服务器 Trainium2 UltraServer,能支撑万亿参数AI模型的实时推理性能。

亚马逊云科技早在re:Invent 2023宣布推出企业级生成式 AI 助手——Amazon Q,专门用于满足办公场景需要,可以根据客户业务进行定制。今年4月30日,亚马逊云科技宣布Amazon Q正式可用,如今Amazon Q持续创新,发挥威力。

新发布从大模型到芯片,从存储到数据库,覆盖了生成式AI全栈架构——基础架构层、中间层和应用层。可以说,这次亚马逊云科技是祭出了AI领域的全家桶,打造一个生态体系。

在早期的AI发展阶段,AI应用主要集中在少数几个领域,如语音识别、图像处理等。这些领域的研究和开发工作往往由少数几家公司或研究机构即可独立完成,犹如“独奏”一般。现如今,AI技术的应用范围迅速扩展,从智能汽车、智能家居、智能穿戴,到政务、金融、教育等千行百业,并加速渗透融合出新业态、新模式,促使整个产业生态进入多领域、多主体协同发展的“大合奏”阶段。这就到了AI玩家角逐综合实力的阶段了。

IDC在《2024 AI原生应用生态白皮书》指出,为促进AI技术与实体经济深度融合与联动发展,行业正在积极倡导从单一的AI原生应用转向建设全面的AI原生应用生态体系。其中,这一转型的核心战略在于搭建跨行业、跨领域的完整生态系统。

随着此番亚马逊云科技打出了一套生态系统组合拳,自此,AI王者亚马逊云科技与追逐者的差距也开始进一步拉大。

2、开放平台的威力:自研+第三方模型的接入

值得关注的是,亚马逊云科技在2024 re:Invent 大会上祭出AI“全家桶”中,大模型是其中最靓丽的一道风景线。我们将「大模型」,作为观察今年亚马逊云科技re:Invent大会的重要切入点。

2024 re:Invent大会上发布了其自研的全新大模型系列——Amazon Nova!堪称为“非常6+2”。这也是Amazon Nova系列基础模型首次亮相。

Amazon Nova基础模型有6款自研基础模型,提供领先性能与高性价比。

(1)Nova Micro:文生文模型,低延迟低成本;

(2)Nova Lite:系列中最低成本快速处理图片、视频、文字输入的多模态模型;

(3)Nova Pro:性能和成本达到平衡的多模态模型;

(4)Nova Premier:系列中最强大的多模态模型,适用于复杂推理任务,模型蒸馏的最佳教师模型;

(5)Nova Canvas:图片生成模型,支持生成和编辑图像,提供配色方案和布局控件,并内置有安全控件,用于可追溯性的水印和用于限制有害内容生成的内容审核;

(6)Nova Reel:视频生成模型,可根据关键词或可选的参考图像生成6秒视频,支持用户调整摄像机运动以生成具有平移、360度旋转和缩放的视频。后续可支持生成2分钟视频。

据了解,亚马逊云科技还将在明年发布2款自研大模型。(1)Amazon Nova Speech-to-Speech:语音输入与生成模型;(2)Amazon Nova Any-to-Any:任意模态输入,任意模态输出。

如果说,自研大模型是亚马逊云科技的大模型的基本色,那么此番亚马逊云科技的大模型开放之路则是最大的亮色。

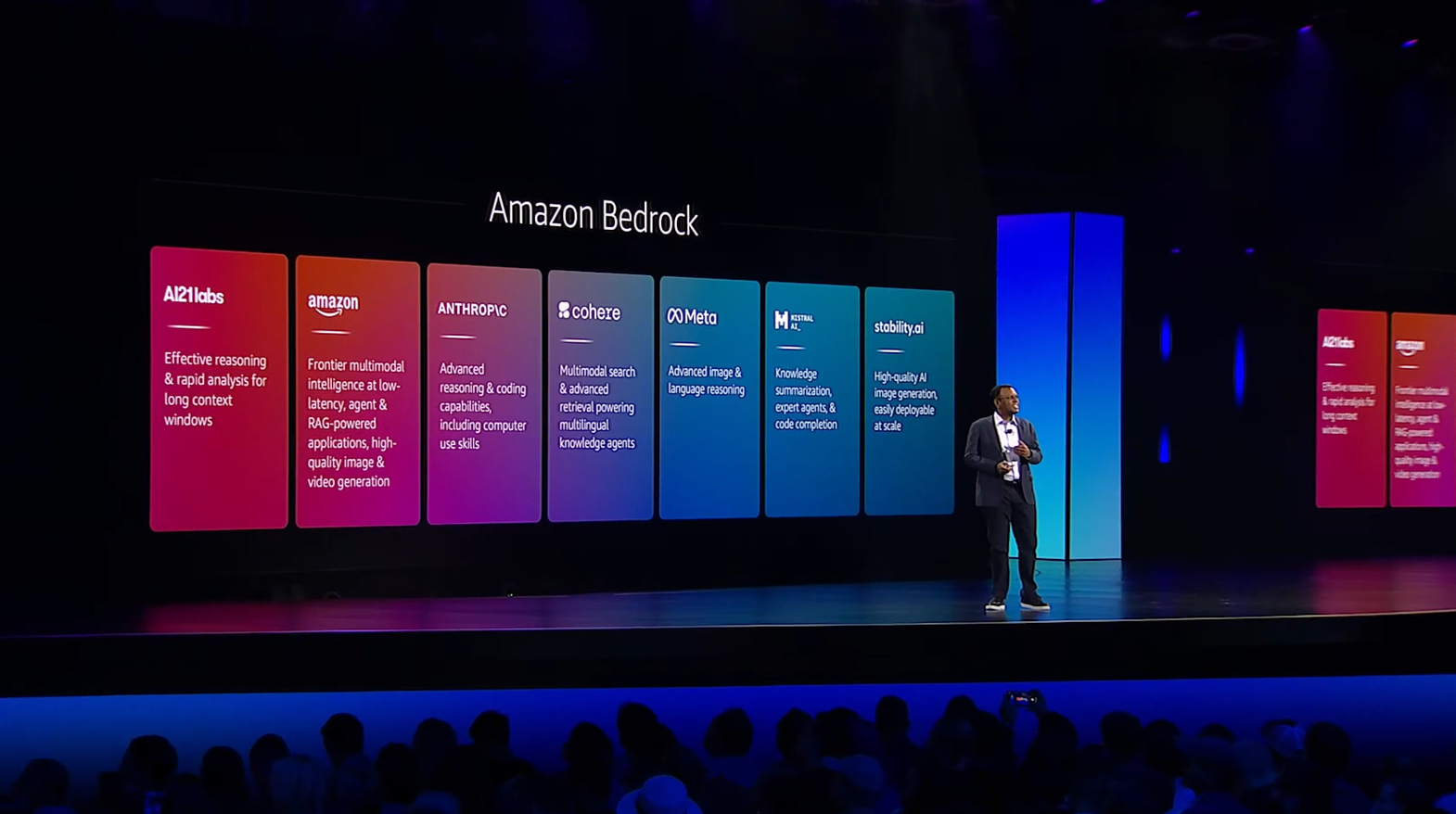

除了自研大模型之外,此次2024 re:Invent 大会上亚马逊云科技宣布推出Amazon Bedrock Marketplace,这类似于一个大模型的开放平台。除了亚马逊云科技自研的大模型,还有三大第三方大模型正式登陆这个平台。

其一、专为软件开发设计的代码生成工具Poolside;其二、最新的文本转图像大模型Stable Diffusion 3.5;其三、视频生成模型Luma Al。这样,就让亚马逊云科技的大模型十分丰富,目前Amazon Bedrock Marketplace上能为客户提供的大模型达到了100多个。

这100多款领先的大模型为客户提供广泛的自研的大模型选择,不留“木桶短板”。毕竟,没有一个大模型可以一统天下,大多数客户会为特定应用使用多个模型。所谓,选择决定一切!需要用模型的时候,最关键的是,有很多可选的自由!

这是亚马逊云科技以开放心态将大模型向外开放的一步大棋,就和腾讯当年以微信为依托推出开放平台一样。

随着越来越多的关系着各行各业的大模型的介入,亚马逊云科技的AI大模型有望重构市场生态。本质上,大模型就是处理数据的更高阶能力,有了这条数据处理能力高速公路,不同规模的企业都能在在这条高速公路上飞速前进。自此,亚马逊云科技也可在这个这条公路上迅速做大、做强。

3、To B端大模型可期 什么是真正AI大模型?

为什么各行各业的客户都选择了亚马逊云科技的大模型?

在近日召开的re:Invent2024上, 亚马逊云科技人工智能和数据部门副总裁Swami发表了长达数小时的演讲,揭晓了上述问题的答案。

这个人工智能创新的新时代汇集了从第一个人工神经网络开始的几十年的研究和科学进步,即感知器模型。而反向传播使得多层模型的有效训练成为可能,也揭示了无监督预训练的巨大潜力。Swami指出,通过云提供的海量数据集和专业计算的融合为人工智能的蓬勃发展创造了完美的条件。

“现在我们到达了生成人工智能的另一个引爆点。新的工具和用户界面正以前所未有的速度实现广泛采用,推动效率并释放我们所有人的创造力。你看客户服务代表正在使用人工智能在几秒钟内起草个性化的客户响应,销售人员正在大规模生成引人注目的广告副本和图像,开发人员正在利用真正的帮助来消除端到端软件开发过程中的繁重工作。”

在Swami看来,随着越来越多的客户希望在多个使用案例中利用这些类似的数据集,他们不想在多个服务之间跳转来完成工作。这其中有巨大的机会,可以利用大数据分析、机器学习和现在真正的融合来创造一种新的统一体验,这将加速他们的工作流程并增强协作。“从根本上说,我们正在重新设想您将通过最大限度地提高培训效率和降低成本来构建和扩展基础模型的方式。”

亚马逊云科技的Amazon SageMaker AI代表了数据和世界的另一个创新融合。它是建立在几十年的神经网络研究之上的,使深度学习首次变得更容易访问和可扩展,它是分布式系统和用户体验设计的突破和计算能力的顶峰。Amazon SageMaker AI为客户提供了工具和工作流程,消除了机器学习和分析生命周期中的繁重工作,从数据准备到修改模型,再到进行训练以增加人类观察能力的所有这些事情,它提供了所有的工具,并将它们集中在一个地方。

这就是为什么成千上万的客户正在使用Amazon SageMaker AI,用数据来训练和部署他们的基础模型。

从整个AI行业来看,AI大模型火了快一年了。大模型厂商们都还在不断完善大模型开发流程,推行零代码开发,想来这个新生态的蛋糕还能做得更大。目前,这一阶段属于大模型行业的产业导入期,大模型的垂直领域应用是主线,更侧重于To B端。

对于To B业务而言,很多行业内的大模型,只是性感的概念,实质上改变不大。虽然有各种参数鼓吹,很多都是企业宣传的噱头。特别是在今年早期大模型刚火的阶段,本土云计算厂商对自家大模型的展示往往会采用很让人匪夷所思的能力,比如作诗、作图、回答脑筋急转弯等等。

到底什么才是真正的大模型王者?其行业标准又是怎样的?经过近一年的迭代,大模型厂商们更应该聚焦产业To B落地做实事。此种情况下,实用才是大模型真正的检验标准。

总体看来,亚马逊云科技的大模型有两大杀手锏:极致的性价比+过硬的产品力,不比参数,重在易用、好用,一句话:实用至上,发力to B端。

对于当代企业客户要而言,使用生成式AI不再是顾虑,而是必选项。但是,如何选择适合的自己,却依旧困扰着大多数企业,其背后所考虑的是一系列围绕“经济账”所展开的综合性问题。

Micro、Lite和Pro的价格比Amazon Bedrock中各自智能类别中性能最佳的模型便宜75%。它们也是Amazon Bedrock中各自智能类别中速度最快的模型。

现实中,金山办公海外版——WPS AI,就是基于Amazon Bedrock支持的Anthropic Claude 3系列模型,为用户提供包括语义检查、内容改写、文档润色和一键生成PPT等功能。自WPS AI海外版开启测试以来,通过亚马逊云科技的大模型极大加快了WPS AI功能推出的进程,上线时间缩短至2个月,并有效为WPS节约35%的成本。

而店匠科技也是应用Claude 3模型构建智能AI客服,辅助商家的运营人员回答常规性与重复性问题。最终,店匠科技解决客户问题的平均时间减少70%,客服成本下降了40%。此外,店匠科技还应用Amazon Bedrock来调用Claude 3模型运行推理,可以实现多语言搜索的统一处理,通过理解消费者行为和商品信息,提高搜索结果的匹配度以及智能商品排序效果,从而帮助商家提升商品点击率和店铺转化率,增加了20%的搜索推荐收入。

生成式AI的发展就是一个数据处理的历史,从最开始的收集、处理数据,到今天的构建各种AI大模型,只是处理的流程、过程发生了变化,不断进阶。

正如亚马逊云科技人工智能和数据部门副总裁Swami在2024 re:Invent 大会上所言:“今天,我们站在一个类似的生成式人工智能的汇聚点上。我们发提供了超过100个新功能来帮助客户更快、更高效地构建他们的模型。你需要一个新的工具和功能来支持所有这些模型的训练和推理,建立和训练这些大型基础模型是复杂的,需要深入的机器学习专业知识。”

本质上,就是亚马逊云科技不断训练大模型,提高资源利用率,为客户释放增量价值。因为,我们生活在一个计算机资源有限且昂贵的世界,很难最大限度地利用和有效地分配资源。

“我们目前在模型培训方面面临着一个关键的转折点。随着这些模型变得越来越复杂,我们正面临着前所未有的计算机资源、能源消耗和数据质量的挑战。”Swami Siva举例,假设你有一千个加速器,白天有两个被大量用于推理,但晚上,这些昂贵的资源中有很大一部分是闲置的,推理需求可能很低。为此,亚马逊云科技开发了动态分配计算机资源的解决方案,还对计算分配和利用进行实时分析和洞察。从而帮助客户将加速计算的利用率提高到90%以上。

可以说,如果不实用,各种胡里花哨的参数都是假把式。只有预置好“自研+开放式的第三方”大模型,才真正实用,才能提升效率,避免浪费,降低客户使用门槛,真正解决客户的痛点,也才对客户有最大的俘获力。

总之,云计算未来可期,亚马逊云科技的大模型发展更可期。从这点来看,作为AI巨头的亚马逊云科技的2024 re:Invent或将掀起一股“做实事提供最丰富AI大模型”的新风,并引发别的玩家跟进。若果真如此,整个AI领域将是一番新景象。

不妨让大模型的实用之风刮得更猛点,这样于企业、于消费者、于整个产业都是一件幸事!(完)